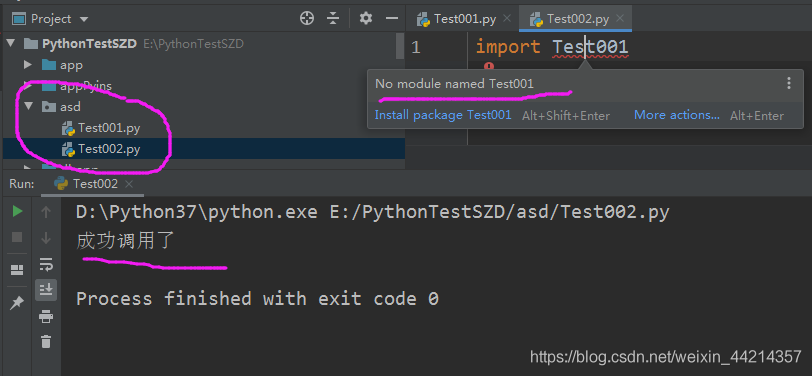

pycharm如何导入本地文件?(python怎么从本地文件读出数据)

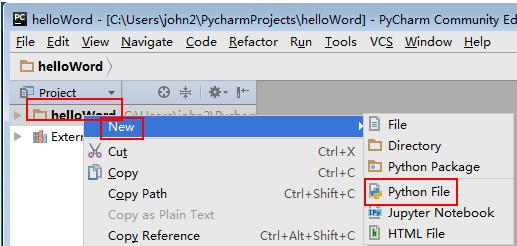

pycharm如何导入本地文件?

具体操作步骤如下:

(图片来源网络,侵删)

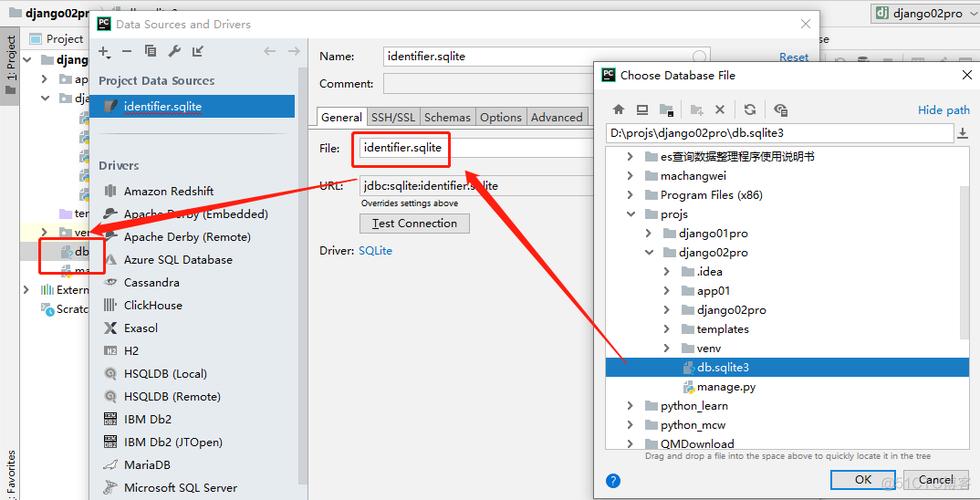

(图片来源网络,侵删)1、第一进入PyCharm的设置面板;

2、进入后点击Porject interpreter,点击右上角的add;

3、点击Existing environment这个选项,然后选择interpreter;

(图片来源网络,侵删)

(图片来源网络,侵删)4、在弹出来的窗口中选择你的python安装目录;

5、查找目录位置,在windows中可以打开cmd;

6、输入where python macos中,可以打开终端,输入which python;

(图片来源网络,侵删)

(图片来源网络,侵删)7、把打印出来的目录复制到上面即可

8、点击ok,然后点击apply,即可将本地模块导入PyCharm,保存即可。

通过数据读取的方式导入本地文件,以xlsx文件为例。

1、本地文件直接拖入pycharm项目中,然后通过pandas包read_excel函数读取文件即可。

2、将文件放入电脑指定文件夹,同样放入pandas包,在read_excel函数中加入读取路径,然后通过read_excel函数读取。

如何用python爬取数据?

Python可以通过以下步骤来爬取数据:1. 导入所需的库,如requests和BeautifulSoup。

2. 使用requests库发送HTTP请求,获取目标网页的内容。

3. 使用BeautifulSoup库解析网页内容,提取所需的数据。

4. 对提取的数据进行处理和清洗,使其符合需求。

5. 将处理后的数据保存到文件或数据库中,或进行进一步的分析和可视化。

Python是一种功能强大且易于学习的编程语言,拥有丰富的第三方库和工具,使其成为数据爬取的首选语言。

requests库可以方便地发送HTTP请求,BeautifulSoup库可以灵活地解析HTML或XML文档,两者的结合可以快速、高效地爬取网页数据。

除了requests和BeautifulSoup库,还有其他一些常用的库可以用于数据爬取,如Scrapy、Selenium等。

此外,爬取数据时需要注意网站的反爬机制和法律法规的限制,遵守爬虫道德规范,以确保合法、合规的数据获取。

同时,数据爬取也需要考虑数据的存储和处理方式,以便后续的数据分析和应用。

使用Python爬取数据需要掌握以下几个步骤:

1. 确定目标网站:确定要爬取的数据来源,可以通过搜索引擎、网络信息抓取工具等途径找到目标网站。

2. 获取网页内容:使用Python中的requests库发送HTTP请求,获取目标网站的网页内容。

3. 解析网页内容:使用Python中的BeautifulSoup库解析网页内容,提取需要的数据。

4. 保存数据:将提取到的数据保存到本地文件中,可以使用Python中的csv、excel等库将数据保存为文件格式。

在Python中,你可以使用各种库来爬取数据,其中最常用的可能是 requests、BeautifulSoup 和 Scrapy。下面我将给你展示一个基本的网页爬取例子。在这个例子中,我们将使用 requests 和 BeautifulSoup 来爬取网页上的数据。

第一,你需要安装这两个库。如果你还没有安装,可以通过以下命令来安装:

python

pip install requests beautifulsoup4

接下来是一个基本的爬虫程序示例,这个程序将爬取一个网页上的所有链接:

python

import requests

from bs4 import BeautifulSoup

def get_links(url):

response = requests.get(url)

到此,以上就是小编对于python怎么从本地文件读出数据库的问题就介绍到这了,希望这2点解答对大家有用。