怎么去重?(怎么去重复在excel)

数据去重技术是数据处理过程中一个常见的需求,用于消除重复的数据条目,提高数据质量,本文将详细介绍数据去重的理论、方法与实践,以便读者能够深入了解并掌握这一技术。

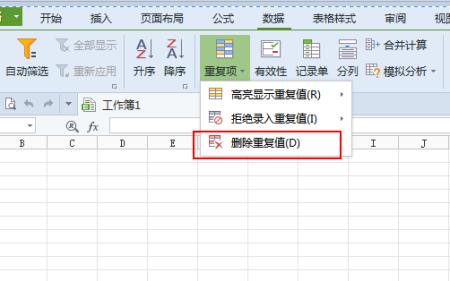

(图片来源网络,侵删)

(图片来源网络,侵删)数据去重理论

数据去重的基本原理是通过比较数据集中的记录,找出并删除重复的记录,这个过程需要对数据集进行遍历,通过一定的比较算法来判断记录是否重复,常用的比较算法有基于哈希值的比较、基于相似度的比较等,不同的比较算法有各自的优缺点,应根据具体场景选择合适的算法。

数据去重方法

1. 基于哈希值的数据去重

这种方法利用哈希函数将记录映射为哈希值,通过比较哈希值来判断记录是否重复,这种方法的优点是速度快、效率高,适用于大规模数据集的去重,哈希函数可能产生冲突,导致误判。

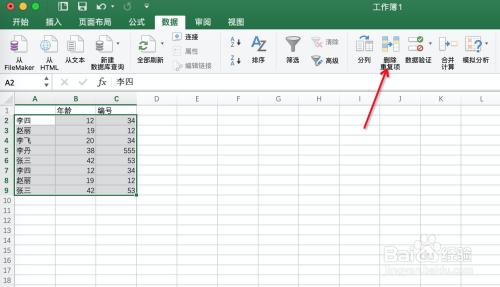

(图片来源网络,侵删)

(图片来源网络,侵删)2. 基于相似度的数据去重

这种方法通过计算记录之间的相似度来判断是否重复,相似度可以采用文本相似度、图片相似度等多种方式计算,这种方法适用于非结构化数据的去重,如文本、图像等,计算相似度可能较为耗时,不适用于大规模数据集的去重。

数据去重实践

在实际应用中,数据去重技术广泛应用于各种场景,如数据库去重、搜索引擎去重、数据清洗等,以下是一个数据去重的实践案例。

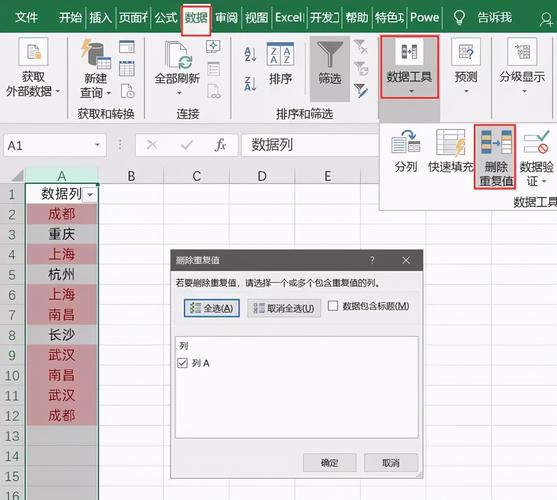

(图片来源网络,侵删)

(图片来源网络,侵删)某电商公司在运营过程中发现,由于数据源的问题,商品数据库中存在大量重复的商品信息,导致商品搜索结果不准确,影响了用户体验,为了解决这一问题,公司采用了基于哈希值的数据去重方法对商品数据库进行去重,通过哈希函数将商品信息映射为哈希值,然后比较哈希值找出重复的商品信息,最后删除重复的商品信息,经过数据去重后,商品搜索结果的准确性得到了显著提高,用户体验也得到了改善。

总结与展望

数据去重技术是数据处理过程中的重要一环,能够提高数据质量,提升数据处理效率,本文介绍了数据去重的理论、方法与实践,包括基于哈希值的数据去重和基于相似度的数据去重等方法,在实际应用中,应根据具体场景选择合适的数据去重方法,随着大数据和人工智能技术的不断发展,数据去重技术将迎来更多的应用场景和挑战,未来研究可以关注更高效、更准确的去重算法和技术。